Técnicas de remuestreo: bootstrapping.

El bootstrapping es una técnica de remuestreo que permite hacer cálculos imposibles por otra vía cuando la muestra es pequeña.

Eso es el bootstrapping. Una idea imposible de llevar a cabo. Además de un palabro intraducible, claro está.

El nombre tiene relación con la especie de correas (straps, en inglés) que tienen las botas (boots, también en inglés) en su parte superior, sobre todo esas botas de vaqueros que vemos en las películas. Bootstrapping es un término que, al parecer, hace referencia a la acción de elevarse a uno mismo del suelo tirando simultáneamente de las correas de las dos botas. Como os dije, una tarea imposible gracias a la tercera ley de Newton, el famoso principio de acción y reacción. He buscado y rebuscado términos adecuados para traducirlo al castellano, pero no he encontrado ninguno que me agrade, así que se admiten sugerencias al respecto.

Bootstrapping

El bootstrapping es una técnica de remuestreo que se emplea en estadística cada vez con más frecuencia gracias a la potencia de los ordenadores actuales, que permiten hacer cálculos que antes podían ser inconcebibles. Quizás su nombre tenga que ver con su carácter de tarea imposible, porque el bootstrapping se utiliza para hacer posibles tareas que podrían parecer imposibles cuando el tamaño de nuestras muestras es muy pequeño o cuando las distribuciones están muy sesgadas, como la obtención de intervalos de confianza, de pruebas de significación estadística o de cualquier otro estadístico en el que estemos interesados.

Como recordaréis de cuando calculamos el intervalo de confianza de una media, podemos hacer el experimento teórico de obtener múltiples muestras de una población para calcular la media de cada muestra y representar la distribución de las medias obtenidas de las múltiples muestras. Es la llamada distribución de muestreo, cuya media es el estimador del parámetro en la población y cuya desviación estándar es el llamado error estándar del estadístico que nos permitirá calcular el intervalo de confianza que deseemos. De esta forma, la extracción de muestras repetidas de la población nos permite hacer descripciones e inferencias estadísticas.

Pues bien, el bootstrapping es algo parecido, pero con una diferencia fundamental: las muestras sucesivas se extraen de nuestra muestra y no de la población de la que procede. El procedimiento sigue una serie de pasos repetitivos.

En primer lugar extraemos una muestra a partir de la muestra original. Esta muestra debe extraerse utilizando un muestreo con reposición, de tal forma que algunos elementos no serán seleccionados y otros lo podrán ser más de una vez en cada muestreo. Es lógico, si tenemos una muestra de 10 elementos y extraemos 10 elementos sin reposición, la muestra obtenida será igual a la original, con lo que no ganamos nada.

De esta nueva muestra se obtiene el estadístico deseado y se utiliza como estimador de la población. Como este estimador sería poco preciso, repetimos los dos pasos anteriores un gran número de veces, obteniendo así un número alto de estimaciones.

Ya casi estamos. Con todos estos estimadores construimos su distribución, que llamamos distribución de bootstrap, y que representa una aproximación de la verdadera distribución del estadístico en la población. Lógicamente, para esto hace falta que la muestra original de la que partimos sea representativa de su población. Cuánto más se aleje, menos fiable será la aproximación de la distribución que hemos calculado.

Por último, con esta distribución de bootstrap podemos calcular el valor central (el estimador puntual) y sus intervalos de confianza de forma similar a como hacíamos para calcular el intervalo de confianza de una media a partir de la distribución de muestreo.

Veamos un ejemplo

Como veis, un método ingenioso que a nadie se le ocurriría poner en práctica sin la ayuda de un programa de estadística y un buen ordenador. Vamos a ver un ejemplo práctico para entenderlo mejor.

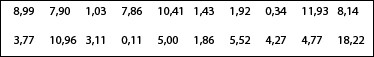

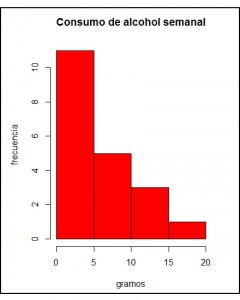

Supongamos por un momento que queremos saber cuál es el consumo de alcohol en un grupo determinado de personas. Reunimos 20 individuos y calculamos su consumo de alcohol en gramos semanales, obteniendo los siguientes resultados:

En este caso la media no sería buena medida de tendencia central, así que preferimos calcular la mediana. Para ello, podemos ordenar los valores de menor a mayor y hacer la media entre los que ocupan los lugares décimo y undécimo. Yo me he molestado en hacerlo y sé que la mediana vale (4,77+5)/2 = 4,88.

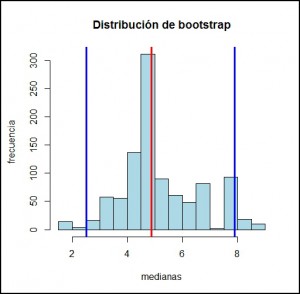

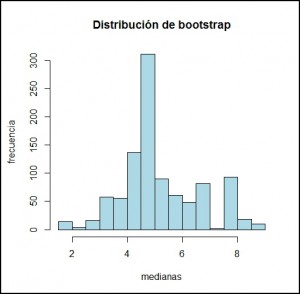

Así que obtengo 1000 muestras con reposición de mi muestra original y calculo la mediana de las 1000 muestras. La distribución de bootstrap de esas 1000 medianas aparece representada en el segundo histograma. Como puede comprobarse, se parece a una distribución normal, cuya media es 4,88 y cuya desviación estándar es 1,43.

Bueno, ya podemos calcular nuestro intervalo de confianza para hacer la estimación poblacional. Podemos hacerlo de dos formas. La primera, calculando los márgenes que engloban el 95% de la muestra (calculando los percentiles 2,5 y 97,5) y que veis representados en el tercer gráfico. Yo he utilizado el programa R, pero puede hacerse de forma manual utilizando fórmulas para el cálculo de percentiles (aunque no es muy recomendable, ya que hay 1000 medianas que ordenar). Así, obtengo una mediana de 4,88 con un intervalo de confianza del 95% de 2,51 a 7,9.

La otra forma es recurriendo al teorema central del límite, que no podíamos usar con la muestra original pero sí con la distribución de bootstrap. Sabemos que el intervalo de confianza del 95% será igual a la mediana más menos 1,96 veces el error estándar (que es la desviación estándar de la distribución de bootstrap). Luego:

IC 95 = 4,88 ± 1,96 x 1,43 = 2,08 a 7,68.

Como veis, se parece bastante al que habíamos obtenido con la aproximación de los percentiles.

Nos vamos…

Y aquí lo dejamos, antes de que alguna cabeza se recaliente demasiado. Para animaros un poco, todo este rollo puede evitarse si se utiliza directamente un programa como R, que calcula el intervalo, y hace el bootstrapping si es necesario, con una instrucción tan sencilla como el comando ci.median() de la librería asbio.

Nada más por hoy. Solo deciros que el bootstrapping es quizás la más famosa de las técnicas de remuestreo, pero no la única. Hay más, algunas también con nombre peculiar como jacknife, pruebas de aleatorización y permutación o prueba de validación cruzada. Pero esa es otra historia…